Xavier Azalbert, France-Soir

La guerre de l'information : contrôle humain, censure et confiance à l'épreuve de la crise sanitaire analysés à l'OTAN

Résumé : dans la guerre de l'information, où l'IA et les réseaux sociaux amplifient récits et censure, la confiance publique vacille. Le symposium NATO HFM-377 (2024) propose des cadres comme AMLAS, LoR et AIMS pour garantir un contrôle humain éthique sur l'IA militaire, face à la propagande computationnelle. Mais l'étude de Boeke et Mittemeijer-Ooteman sur le COVID-19 expose une censure massive : des vérités sur l'origine du virus, les aérosols, les masques, les vaccins et les traitements précoces ont été étouffées comme désinformation par des gouvernements, l'OMS, des fact-checkers opaques et des algorithmes d'IA. Cette répression, orchestrée sous pression politique et entachée de conflits d'intérêts, rappelle des dérives historiques : Galilée censuré pour l'héliocentrisme, Hertel muselé pour ses travaux sur les micro-ondes, l'étude Recovery manipulant l'hydroxychloroquine à des doses toxiques, et Wakefield diabolisé pour ses questions sur le vaccin ROR. La marginalisation de FranceSoir, accusé à tort de désinformation pour ses analyses critiques, incarne ce scandale.Les impacts sont dévastateurs : science entravée, sociétés polarisées, libertés bafouées. Restaurer la confiance exige transparence, débat ouvert et régulation éthique : comités indépendants, fact-checkers audités, mécanismes d'appel, et éducation numérique. Sans cela, la démocratie risque de succomber à une vérité imposée, loin de la liberté et de la science.

Article

Dans un monde où un tweet peut enflammer une polémique mondiale et où l'intelligence artificielle (IA) peut censurer une vérité en un clic, la guerre de l'information redéfinit les enjeux de pouvoir, de vérité et de démocratie. Des documents récents (458 pages d'analyses et 383 pages de présentations powerpoint), issus du symposium NATO HFM-377 organisé par le Conseil des Sciences et Technologies de l'Otan (octobre 2024, Amsterdam) et plus particulièrement de l'analyse de Boeke et Mittemeijer-Ooteman sur la censure pendant la crise de la COVID-19, jettent une lumière crue sur ces défis.

L'objectif du symposium HFM (Facteurs Humains et Médecine) était d'explorer comment garantir un contrôle humain sensé (Meaningful Human Control, MHC) sur les systèmes IA dans les opérations militaires, tandis que l'analyse spécifique sur la crise covid, le document MP-HFM-377-21 révèle une censure massive d'hypothèses scientifiques, qualifiées à tort de désinformation, pendant la pandémie. Ces pratiques, qui rappellent des précédents comme les persécutions de Galilée, la jurisprudence Hertel, ou l'étude frauduleuse Recovery, ont brisé la confiance publique et polarisé les sociétés.

Pour le grand public, ces questions touchent à la liberté d'expression, à la transparence et à la résilience face à la manipulation. Cet article décrypte les cadres techniques du symposium (AMLAS, LoR, AIMS), les définitions de la désinformation, les acteurs de la censure et les impacts sociétaux. Des médias, comme France-Soir, ont été marginalisés pour avoir osé questionner les narratifs officiels, soulignant l'urgence de protéger les droits fondamentaux, le débat démocratique et de restaurer la confiance.

Quand l'information devient une arme

Avec un champ de bataille invisible, où les armes sont des algorithmes, des hashtags et des narratifs, bienvenue dans la guerre de l'information. Un terrain où une campagne de propagande peut manipuler des millions de personnes en quelques heures. Le symposium NATO HFM-377, organisé à Amsterdam en octobre 2024, a réuni 180 experts de 28 pays pour répondre à une question brûlante : « comment garder l'humain aux commandes face à des systèmes IA toujours plus puissants ? » Et l'analyse de Boeke et Mittemeijer-Ooteman revisite la crise de la COVID-19, révélant comment des gouvernements, des organisations internationales et des algorithmes ont étouffé des vérités scientifiques sous prétexte de lutter contre la désinformation.

Qu'est-ce que la désinformation ? Selon le symposium et les documents que France-Soir a pu consulter, la mésinformation désigne des fausses informations diffusées sans intention de tromper, tandis que la désinformation implique une intention malveillante, visant un préjudice ou un profit (Union européenne, 2018). Ces définitions, claires sur le papier, se sont heurtées à une réalité chaotique pendant la pandémie, où des hypothèses légitimes ont été balayées comme des « conspirations » ou « théorie du complot ». Ce double prisme – technique et historique – invite à réfléchir :

comment gérer l'information sans sacrifier la liberté ni la vérité ?

Le symposium OTAN : garder l'humain au cœur de l'IA (Intelligence Artificielle)

Des outils pour dompter l'IA : au cœur du symposium, un groupe de chercheurs dirigé par Lange propose deux cadres pour certifier les systèmes autonomes basés sur l'IA, garantissant qu'ils restent alignés sur les intentions humaines.

Le premier, AMLAS (Assurance of Machine Learning for Autonomous Systems), est une méthodologie en six étapes qui intègre la sécurité dès la conception des modèles d'apprentissage automatique. Imaginez un système IA chargé de détecter une campagne de propagande computationnelle sur les réseaux sociaux : AMLAS s'assure qu'il ne diffuse pas par erreur des informations biaisées ou ne cible pas des groupes vulnérables.

Le second, LoR (Level of Rigor ou Niveau de Rigueur), évalue la rigueur du développement de ces systèmes, avec des niveaux de confiance adaptés aux risques. Dans une mission militaire sensible, un LoR élevé exige des tests exhaustifs pour éviter des dérapages.

Ces outils ne sont pas réservés aux stratèges militaires. Ils répondent à une crainte partagée par tous : que l'IA devienne une boîte noire, prenant des décisions sans contrôle. « C'est comme installer un frein d'urgence sur une voiture autonome », explique un ingénieur présent au symposium.

Mais, pour convaincre le public, il faudra plus que des promesses – il faudra de la transparence.

AIMS : L'IA, un coéquipier sous surveillance

Une autre analyse, signée Cooke et al., présente l'AI Manager System (AIMS), un système qui surveille en temps réel les équipes homme-machine dans des opérations complexes, comme les missions spatiales ou les opérations multi-domaines (terre, air, cyber). AIMS utilise des capteurs pour analyser les communications, la physiologie des opérateurs, et leur positionnement. Lorsqu'une panne ou une surcharge cognitive est détectée, AIMS propose des solutions pour stabiliser le système. Une preuve de concept montre qu'il peut distinguer une réponse résiliente (qui rétablit l'équilibre) d'une réponse fragile.

Pour le grand public, AIMS évoque un futur où l'IA agit comme un coéquipier fiable, mais toujours sous supervision humaine. « C'est un outil qui peut sauver des vies, mais seulement si les opérateurs savent l'utiliser », note un chercheur. Cette dépendance au facteur humain est une leçon universelle, valable aussi pour les citoyens confrontés à des technologies automatisées, des assistants vocaux aux algorithmes de recommandation.

L'humain à chaque étape

Boardman et McNeish, du Département de Science et Technology du ministère de la Défense britannique (MOD) s'appuyant sur quatre ans de recherches du groupe OTAN HFM330, insistent sur l'importance d'un contrôle humain adapté à chaque phase du cycle de vie des systèmes IA : conception, développement, déploiement. Cette approche alloue les tâches entre humains et machines pour optimiser la performance tout en respectant les normes éthiques. Par exemple, dans la lutte contre une campagne de propagande, l'IA peut analyser des millions de tweets, mais un humain doit valider les conclusions pour éviter des biais.

Ce principe rassure : l'IA n'est pas un maître, mais un outil. Pour le public, c'est une promesse que la technologie peut être domestiquée, à condition que les processus soient transparents et les opérateurs formés.

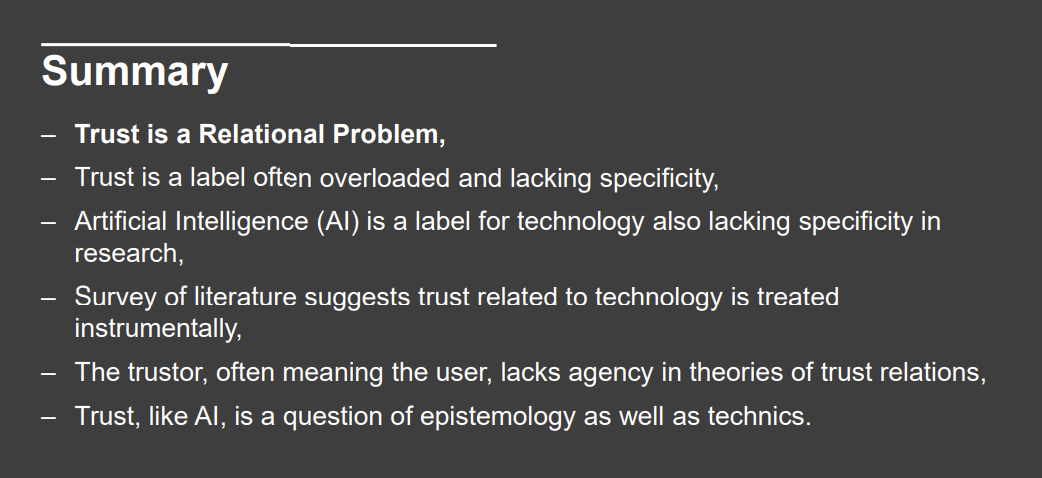

La confiance, un puzzle socio-technique

Dr. Barrett-Taylor, expert défense et sécurité et Dr. Byrne proposent une vision novatrice : l'IA n'est pas une entité isolée, mais un réseau d'acteurs – humains, institutions, technologies. Leur approche, basée sur la théorie des assemblages socio-techniques, distingue la confiance (envers les institutions qui créent l'IA) de la dépendance (envers la technologie elle-même). « Faire confiance à une IA, c'est d'abord faire confiance à ceux qui l'ont conçue », explique Byrne. Cela signifie que la transparence des développeurs et des régulateurs est cruciale.

Pour le grand public, ce cadre démystifie l'IA, souvent perçue comme une boîte magique. Il rappelle que la confiance repose sur des relations humaines, un message clé dans une ère de méfiance croissante envers les institutions.

Combattre la propagande avec éthique

Le philosophe, professor en Ethique et Technolog ie à l'Université de Eindhoven, Santoni de Sio propose de combiner le Value-Sensitive Design (VSD, Conception Sensible aux valeurs), qui intègre des valeurs comme la justice et la liberté dès la conception, avec le MHC. Cela garantit que les systèmes IA restent réactifs aux intentions humaines et responsables. Mais des défis persistent : les IA peuvent mal interpréter les intentions, amplifier des biais, ou entrer en conflit avec des valeurs concurrentes, comme la sécurité contre la liberté d'expression.

Pour le public, le VSD est une lueur d'espoir : des systèmes IA alignés sur des valeurs démocratiques.

Mais il faudra veiller à ce que ces valeurs soient définies avec la participation citoyenne, pas seulement par des élites au contrôle.

La censure pendant la covid-19, une vérité sacrifiée

Une censure à grande échelle

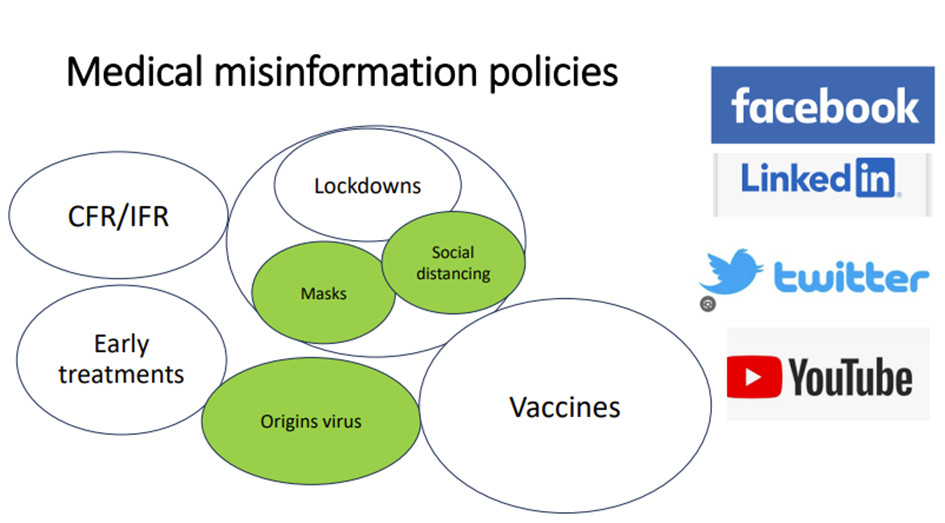

Entre 2020 et 2023, la lutte contre la désinformation a pris des proportions inédites. Selon l'analyse de Boeke et Mittemeijer-Ooteman, Facebook a supprimé 20 millions de publications liées au COVID-19, et YouTube, 1 million de vidéos, souvent sur la base de signalements par des fact-checkers anonymes ou des directives de l'Organisation mondiale de la santé (OMS). Les gouvernements, comme la Maison-Blanche, ont exercé des pressions politiques pour censurer des contenus, tandis que des algorithmes d'IA amplifiaient ces suppressions sans analyse contextuelle.

Trois cas illustrent cette dérive :

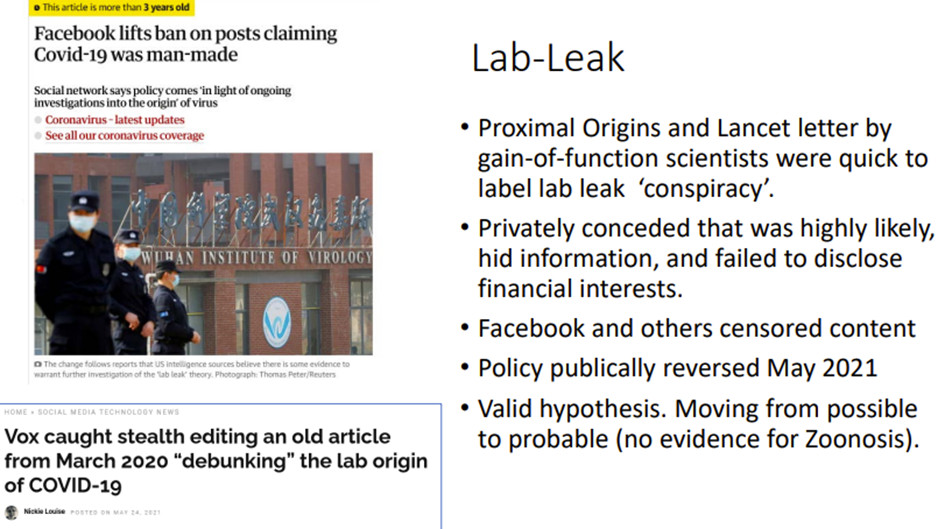

- L'hypothèse de la fuite de laboratoire du virus : Qualifiée de « conspiration raciste», cette hypothèse a été censurée sur les réseaux sociaux jusqu'à ce que l'OMS et les États-Unis la reconnaissent comme plausible en 2021 bien après que le Pr. Montagnier a décrit le travail d'horlogerie moléculaire des inserts du virus. Des conflits d'intérêts, comme les liens entre les auteurs du Lancet Letter et le Wuhan Institute of Virology, ont révélé une manipulation du débat scientifique.

- La transmission par aérosols : l'OMS a minimisé ce mode de transmission, privilégiant les gouttelettes et les surfaces contaminées. Les scientifiques plaidants pour la ventilation, comme Maurice de Hond, ont été bannis de plateformes comme LinkedIn.

- L'efficacité des masques : malgré l'absence de preuves solides, les masques sont devenus obligatoires. Des études, comme celle de Heneghan et Jefferson montrant un effet limité, ont été supprimées par Facebook, qui ajoutait des avertissements de « fausse information».

Les vaccins et les traitements précoces ont également été lourdement censurés, bien que l'analyse de Boeke ne rentre pas dans le détail. Des virologistes et vaccinologues ont été « suspendus » pour avoir questionné l'efficacité ou les risques des vaccins, ou pour avoir exploré des traitements précoces. D'autres comme Jay Bhattacharya a été déclaré « scientifique marginal » pour avoir questionner l'efficacité des mesures de confinement.

Cette censure a étouffé des débats cruciaux, laissant le public dans l'ignorance.

Qui décide de la « désinformation » ?

L'évaluation de la désinformation était contrôlée par un réseau complexe :

Tout d'abord, les gouvernements qui ont poussé les plateformes à agir, parfois sous menace de régulation. Ensuite, l'Organisation Mondiale de la Santé (OMS) a fait des déclarations, souvent hâtives, qui servirent de référence pour les fact-checkers, sans que les médias, ou des agences de presse comme l'AFP, ne vérifient ces déclarations. Une argument d'autorité qui se retrouve utilisé par les fact-checkers - des pseudo-journalistes ou anonymes aux raisonnements biaisés qui contribuaient à blanchir l'information en signalant des contenus sans transparence. Enfin, les algorithmes d'IA qui une fois un contenu marqué comme désinformation, supprimait automatiquement des publications similaires, amplifiant les erreurs, sans aucune intervention humaine. Des contenus vrais ou des signaux faibles étaient marqués comme de la désinformation entrainant des erreurs de type 1 (une vraie hypothèse qui est rejetée par erreur) et de type 2 (l'hypothèse est acceptée par erreur).

Cette opacité rappelle des précédents historiques où des autorités ont imposé leur vérité, au détriment de la science et de la liberté.

Impacts, une confiance brisée

La censure a eu des conséquences profondes.

Tout d'abord, en science, car en muselant le débat, la censure a retardé des avancées, comme la reconnaissance de la transmission par aérosols.

Ensuite sur la société : en 2021, 57 % des personnes interrogées par l 'Edelman Trust Barometer pensaient que les dirigeants exagéraient les dangers du virus. La censure a polarisé les sociétés, les pro-masques craignant les non-masqués.

Enfin, sur les droits : la suppression d'informations valides a violé la liberté d'expression et le droit à l'information, notamment pour des mesures expérimentales comme les masques.

Les dérives de la censure et les leçons du passé

Un usage détourné des outils de modération

La crise de la COVID-19 a mis en lumière une vérité troublante : les outils conçus pour protéger contre la désinformation peuvent devenir des instruments de censure lorsqu'ils sont mal utilisés. Les algorithmes d'IA, guidés par des fact-checkers opaques et des institutions biaisées, ont supprimé des vérités scientifiques sous prétexte de désinformation, causant des dommages durables à la confiance publique.

Plusieurs exemples, historiques et contemporains, illustrent cette dérive.

- Le premier exemple remonte au 17ᵉ siècle, avec Galilée. Condamné par l'Inquisition pour avoir défendu l'héliocentrisme, Galilée a été censuré par une autorité religieuse imposant sa vérité. Son hypothèse, jugée hérétique, était pourtant correcte, mais il a fallu des décennies pour qu'elle soit reconnue. De même, pendant le COVID-19, des scientifiques comme Alina Chan, qui soutenaient l'hypothèse de la fuite de laboratoire, ont été marginalisés, qualifiés de conspirationnistes, alors que leur hypothèse est aujourd'hui jugée plausible.

- Le second exemple concerne la jurisprudence Hertel dans les années 1990. Hans Hertel, un scientifique suisse, a été poursuivi pour avoir publié une étude suggérant que les micro-ondes altéraient les aliments. Malgré des preuves, il a été censuré par des intérêts industriels et des autorités, qui l'ont accusé de propager des fausses informations. La Cour européenne des droits de l'homme a finalement reconnu une violation de sa liberté d'expression, soulignant le danger de laisser des puissances établies définir la vérité. Ce cas résonne avec la censure de scientifiques pendant la COVID-19, comme ceux plaidant pour la ventilation contre la transmission par aérosols.

- Un exemple plus récent est l'étude Recovery, une étude britannique menée en 2020, dont un des bras testait l'hydroxychloroquine. Conçue pour tester ce médicament contre la covid-19, l'étude a administré des doses toxiques (2400 mg le premier jour 9600 mg sur 10 jours, bien au-delà des recommandations et doses considérées comme toxiques) à des patients hospitalisés, donc à un stade avancé de la maladie. Les résultats, montrant une absence d'efficacité et une mortalité importante (27%) mais non statistiquement différente du bras témoin, ont été utilisés pour discréditer l'hydroxychloroquine à l'échelle mondiale, entraînant son abandon comme traitement potentiel.

- Cependant, des critiques ont dénoncé une manipulation frauduleuse : les doses excessives semblent soit une erreur de la part des investigateurs ou destinée à garantir l'échec du médicament, possiblement sous l'influence d'intérêts pharmaceutiques favorisant des traitements plus coûteux, comme le remdesivir ; où même le vaccin, car, l'absence d'alternative médicamenteuse, quatrième condition pour l'approbation d'un vaccin, leur laissait la voie libre. Malgré ces alertes, les voix dénonçant l'étude ont été censurées, qualifiées de désinformation, et les plateformes comme Twitter et YouTube ont supprimé des publications sur ce scandale dénoncé par France-Soir. Cette censure a retardé un débat légitime sur les traitements précoces, privant potentiellement des patients d'options viables.

- Un autre cas marquant est la controverse autour de l'étude d'Andrew Wakefield (1998), qui suggérait un lien entre le vaccin ROR (rougeole, oreillons, rubéole) et l'autisme. Bien que l'étude ait été critiquée pour des failles méthodologiques, Wakefield a été radié et son travail qualifié de désinformation par les autorités sanitaires et les médias. Les plateformes ont systématiquement censuré les discussions sur cette étude, même celles nuancées, sous prétexte de protéger la santé publique. Pourtant, des années plus tard, des études indépendantes ont exploré des liens possibles entre vaccins et effets secondaires rares, montrant que les questions de Wakefield, bien que maladroites, méritaient un débat scientifique. Robert Kennedy Jr et Jay Bhattacharya ont demandé d'avoir les données de fabricants de vaccins et récemment imposés les tests placebo pour les vaccins. Cette censure prématurée a alimenté la méfiance envers les vaccins, un effet boomerang que les autorités n'avaient pas anticipé.

Dans tous ces cas, les outils de modération – fact-checkers et algorithmes – ont été détournés pour imposer une vérité officielle, étouffant des hypothèses valides. La marginalisation de médias critiques comme France-Soir, qui a dénoncé le scandale de l'étude Recovery et d'autres incohérences, illustre ce phénomène. Loin de propager de la désinformation, France-Soir jouait un rôle de signal faible, offrant une analyse critique des narratifs dominants. En le déréférençant, Google et les réseaux sociaux ont privé le public d'une voix essentielle au débat démocratique, renforçant la polarisation et la méfiance.

Pourquoi cela arrive ?

Les dérives de la censure pendant la crise de la covid-19 ne sont pas un accident, mais le résultat d'une convergence de facteurs systémiques qui ont transformé les outils de modération en instruments d'oppression. L'urgence de la crise sanitaire a poussé les gouvernements à privilégier la conformité à court terme, au détriment du débat scientifique. Face à la panique mondiale, les dirigeants ont cherché à contrôler le narratif pour éviter le chaos, exerçant des pressions politiques sur les plateformes comme Facebook et YouTube pour supprimer tout contenu jugé dangereux, même s'il était basé sur des hypothèses légitimes.

Cette approche a conduit à une définition floue de la désinformation, où des vérités scientifiques, comme l'hydroxychloroquine ou la transmission par aérosols, ont été balayées par des fact-checkers souvent anonymes et dépourvus de légitimité scientifique. Les conflits d'intérêt ont joué un rôle central dans ces dérives, avec des institutions comme l'OMS, influencées par des liens financiers avec l'industrie pharmaceutique ou des pressions géopolitiques, imposant des narratifs officiels qui servaient des agendas spécifiques.

Par exemple, l'étude Recovery, financée en partie par des acteurs (Welcome Trust, Bill & Melinda Gates Foundation) ayant des intérêts dans des traitements concurrents, a permis de discréditer l'hydroxychloroquine. De même, les auteurs du Lancet Letter, liés au Wuhan Institute of Virology, ont manipulé le débat sur l'origine du virus, qualifiant l'hypothèse de la fuite de laboratoire de conspiration pour protéger leurs propres intérêts. L'opacité des processus de modération a exacerbé le problème, avec des fact-checkers non identifiés manquant de transparence sur leurs méthodes et leurs affiliations, tandis que les algorithmes d'IA, programmés pour repérer des mots-clés ou des schémas, supprimaient des contenus sans analyse contextuelle.

Cette automatisation a amplifié les erreurs, comme la censure de l'étude danoise sur les masques, pourtant rigoureuse. Ensemble, ces facteurs – urgence, conflits d'intérêts, opacité – ont créé un environnement où la vérité était sacrifiée au profit du contrôle, transformant les outils de modération en armes contre la liberté d'expression et le progrès scientifique.

Restaurer la confiance : un défi pour l'avenir

Restaurer la confiance après les mensonges institutionnels et la censure massive de la crise du COVID-19 est une tâche herculéenne, mais essentielle pour préserver la démocratie et la résilience des sociétés. Les gouvernements et les institutions ont brisé un pacte fondamental avec le public en minimisant des vérités scientifiques, comme la transmission par aérosols, ou en exagérant l'efficacité des masques sans preuves solides. La censure de voix crédibles, qu'il s'agisse de scientifiques dénonçant l'étude Recovery ou de médias critiques comme France-Soir, a creusé un fossé profond, alimentant la méfiance et la polarisation. Les citoyens, se sentant trahis, se tournent vers des sources alternatives, souvent plus fiables que les médias traditionnels subventionnés à millions et donc au service des gouvernement, tandis que les scientifiques, craignant pour leur carrière, s'auto-censurent, limitant le progrès scientifique.

Cette perte de légitimité rend les institutions vulnérables, incapables de mobiliser le public face à de futures crises.

Les documents analysés du symposion NATO HFM-377 offrent des pistes pour relever ce défi. Le symposium NATO insiste sur la transparence comme fondement de la confiance, soulignant que les institutions doivent rendre des comptes sur leurs décisions. Publier les critères de modération, les conflits d'intérêts, et les processus décisionnels est un premier pas pour regagner la confiance du public. De même, les cadres comme AMLAS et LoR montrent l'importance d'un contrôle humain rigoureux pour éviter les dérives des algorithmes. Appliqué à la censure, cela signifie créer des comités indépendants, composés de scientifiques, de juristes et de citoyens, pour évaluer la désinformation avec transparence et équité. L'approche Value-Sensitive Design (VSD), qui intègre des valeurs comme la justice et la liberté dès la conception des systèmes IA, peut également guider la création d'outils de modération respectueux des droits humains.

L'analyse sur la covid-19, quant à elle, conclut que la censure est contre-productive, exacerbant la méfiance au lieu de la dissiper. Elle plaide pour un débat ouvert, où les hypothèses scientifiques, même controversées, sont discutées plutôt que supprimées. Cela implique de reconnaître les erreurs passées, comme la censure de l'hypothèse de la fuite de laboratoire ou des critiques de l'étude Recovery, et de réintégrer les voix marginalisées dans le débat public. Par exemple, les scientifiques qui ont dénoncé les doses toxiques de l'hydroxychloroquine dans Recovery méritent une plateforme pour partager leurs analyses, comme les médias critiques qui ont joué un rôle de sentinelle.

Pour aller plus loin, plusieurs actions concrètes s'imposent. D'abord, les fact-checkers doivent être soumis à une transparence totale, publiant leurs méthodes, leurs affiliations et leurs sources pour éviter les biais. Ensuite, les plateformes doivent instaurer des mécanismes d'appel pour les contenus supprimés par des algorithmes, garantissant un contrôle humain et une justice procédurale. Enfin, l'éducation numérique doit devenir une priorité, formant le public à évaluer les sources et à reconnaître les manipulations sans recourir à la censure.

Ces mesures, inspirées des leçons de la crise et des cadres du symposium, visent à reconstruire un contrat social basé sur l'honnêteté, la transparence et le respect des libertés fondamentales. Comme le dit un proverbe néerlandais cité dans l'étude :

« La confiance vient à pied et part à cheval. » Il est temps de faire les premiers pas.

Conclusion

Le symposium NATO HFM-377 et son analyse sur la censure pendant la COVID-19 révèlent les tensions au cœur de la guerre de l'information. Les cadres comme AMLAS, LoR et AIMS offrent des solutions pour une IA responsable, tandis que la crise expose les dangers de la censure, qui a étouffé des vérités sur l'origine du virus, les aérosols, les masques, les vaccins et les traitements précoces. Les dérives des outils de modération, illustrées par les cas de Galilée, Hertel, l'étude Recovery et ltoutes les controverses scientifiques, montrent comment des autorités peuvent imposer une vérité officielle au détriment de la science. La marginalisation de médias critiques comme France-Soir, loin d'être de la désinformation, était un signal faible d'analyse critique essentiel au débat démocratique.

Restaurer la confiance exige transparence, débat ouvert et régulation éthique. En s'inspirant des leçons du passé et des cadres du présent, nous pouvons construire un avenir où l'IA sert l'humanité sans compromettre la liberté ni la vérité. Le chemin sera long, mais la démocratie en dépend.